|

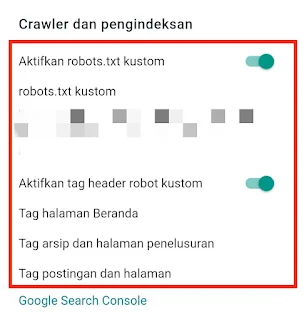

| Ilustrasi Setting Robot.txt |

Setiap bot mesin terlusur untuk crawl blog pasti pertama kali berinteraksi dengan file robots.txt dan aturan perayapan situs web yang Anda miliki. Itu artinya bahwa robots.txt mempunyai peranan penting dalam optimasi SEO, juga untuk optimasi mesin telusur.

Pada kali ini, saya akan membantu Anda serta menjelaskan cara mengatur file robots.txt custom pada Blogger yang baik dan benar untuk mengoptimalkan blog pada mesin pencari.

Fungsi dari file robots.txt

File robots.txt merupakan sebuah cara untuk memberi tahu crawler mesin telusur URL mana yang dapat diakses di situs Anda. File robots.txt juga menginformasikan kepada mesin pencari tentang halaman mana yang harus dirayapi dan atau yang tidak boleh dirayapi.

Oleh karena itu memang sangat penting bagi para blogger, supaya dapat mengontrol fungsi dari bot mesin telusur tersebut.

Dalam file robots.txt, kami mendeklarasikan user-agent, allow, disallow, fungsi sitemap untuk mesin pencari seperti Google, Bing, Yandex, dll.

Biasanya, jika menggunakan tag meta robot untuk semua mesin pencari yang dapat crawler untuk mengindeks postingan blog dan halaman di seluruh web.

Analisis file Robots.txt default dari Blog Blogger

Untuk Setting File robots.txt Custom yang Baik dan Benar pada Blogger. Pertama-tama Anda harus memahami struktur blog Blogger itu sendiri dan menganalisis file robots.txt default.

Secara Default memang tampilan file robots.txt pada Blogger akan terlihat tampak seperti di bawah ini:

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /search

Allow: /

Sitemap: https://www.example.com/sitemap.xml

Hal ini terlihat pada ulasan yang di buat igniel. Dan anda juga dapat melakukannya, akan tetapi saya akan mencoba membuat prespektif yang berbeda namun punya kekuatan dan kegunaan yang bagus.

Baca juga :

- User-Agent- Media Partners-Google: dari file ini menyatakan tipe bot . Ini untuk Google AdSense, yang tidak diperbolehkan (dinyatakan di baris ke-2). Itu berarti iklan AdSense dapat muncul di seluruh situs web.

Jika Anda mempunyai Blog masih tentunya harapan supaya dapat diterima Google Adsense bukan? Maka untuk itu perlu Anda membaca ini "Blog masih sebulan tapi langsung di terima Adsense"

- User-agent (Agen pengguna): adalah * , yang berarti semua bot mesin pencari tidak diizinkan ke / halaman pencarian. Itu berarti tidak diizinkan untuk semua halaman pencarian dan label (struktur URL yang sama).

- Disallow:/Search: ini menentukan bahwa semua halaman selain bagian yang dilarang akan diizinkan untuk crawler oleh mesin telusur.

- Sitemap: Baris ini berisi peta situs posting untuk blog Blogger.

Ini adalah file yang hampir sempurna untuk mengontrol bot mesin pencari dan memberikan instruksi agar halaman dapat crawl atau tidak dirayapi

Harap dicatat, di sini, apa yang diizinkan untuk di crawler tidak akan memastikan bahwa halaman akan di indeks.

Tetapi file ini memungkinkan untuk mengindeks halaman arsip, yang dapat menyebabkan masalah duplikat konten. Artinya akan membuat sampah bagi blog Blogger.

Cara Setting file robots.txt Custom yang baik dan Benar untuk Blog Blogger.

- /search* akan menonaktifkan perayapan semua halaman pencarian dan label.

- Terapkan aturan Disallow /20* ke dalam file robots.txt untuk menghentikan crawling bagian arsip.

- Atur /20* yang akan memblokir perayapan pada semua posting, Jadi untuk menghindarinya, kami menerapkan aturan Izinkan baru untuk bagian /*.html yang memungkinkan bot merayapi posting dan halaman.

https://example.blogspot.com/sitemap-pages.xml

https://www.example.com/sitemap-pages.xml (ini untuk domain khusus)

User-agent: Mediapartners-GoogleDisallow:#below lines control all search engines, and blocks all search, archieve and allow all blog posts and pages.User-agent: *Disallow: /search*Disallow: /20*Allow: /*.html#sitemap of the blogSitemap: https://www.example.com/sitemap.xmlSitemap: https://www.example.com/sitemap-pages.xml

Anda harus mengganti www.example.com dengan domain Blogger atau nama domain khusus Anda.

Misalnya, nama domain kustom Anda adalah www.abc.com, maka peta situs akan berada di https://www.abc.com/sitemap.xml.

Cara pengaturannya robots.txt di atas adalah sebagai bentuk untuk menjadikan blog Anda ramah SEO. Ini juga sebagai cara membantu blog Anda muncul di hasil pencarian

Bagaimana cara mengedit file robots.txt dari blog Blogger?

File Robots.txt ini terletak di tingkat akar situs web. Tapi di Blogger tidak ada akses root, jadi bagaimana cara mengedit file robots.txt pada blogger?

Blogger menyediakan semua pengaturan file root di bagian pengaturannya seperti file robots.txt dan ads.txt. Anda harus masuk ke akun Blogger dan mengedit file robots.txt.

- Buka Dashboard Blogger dan klik opsi pengaturan,

- Gulir ke bawah ke bagian perayap dan pengindeksan,

- Aktifkan robots.txt khusus dengan geser tombol sampai warna hijau.

- Klik pada robots.txt khusus , sebuah jendela akan terbuka, tempel file robots.txt, dan perbarui.

Manfaat dan keuntungan menggunakan Robot.txt pada Blog

- Informasi sensitif dapat dirahasiakan menggunakan robots.txt.

- Dengan bantuan Robots.txt, masalah "kanonikal" dapat dijauhkan atau beberapa URL " Kanonik " juga dapat disimpan. Masalah ini juga disebut masalah "konten duplikat".

- Membantu Google Bot untuk mengindeks halaman